Wer auf iOS als Betriebssystem seiner Wahl verzichten kann, hat die Qual der Wahl sich für eines der zahlreichen Smartphones zu entscheiden, die auf Googles Android basieren. Einer dieser Hersteller nennt sich OnePlus und veröffentlichte kürzlich seine Handys der achten Generation.

OnePlus 8: Außergewöhnliche Bezeichnungen für Gewöhnliches

Das OnePlus 8 gibt es in zwei Ausführungen: sowohl das "normale" als auch mit dem Namenszusatz Pro. Das Pro-Modell wird in den Farben schwarz, grün und blau angeboten. Diese Realität verbirgt sich hinter den besonders klingenden Bezeichnungen "Onyx Black", "Glacial Green" oder auch "Ultramarine Blue". Die Rückseite ist gezeichnet von vielen Kameras. Je nach Gerät gibt es neben dem Hauptsensor eine Ultraweitwinkel-, Zoom-, Makro- als auch die sogenannte "Farbfilter"-Kamera. Bei beiden Geräten präsentiert sich auf der Vorderseite ein randloses OLED-Panel mit einem 19,8:9" Seitenverhältnis, das zu den Seiten abgerundet ist. Im Gegensatz zu der Vorgänger-Serie fährt die Front-Kamera nicht mehr aus dem Gerät heraus, sondern wanderte als Loch-Kamera in die linke obere Ecke des Bildschirms. In der Theorie müsste die Gesichtserkennung zur Entsperrung dadurch schneller arbeiten. Alternativ ist nach wie vor ein Fingerabdrucksensor im Display verbaut.

Viele Köche verderben den Brei! -Oder etwa nicht?

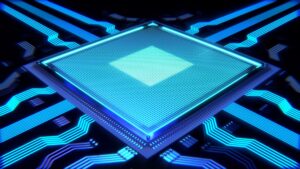

Die notwendige Rechenleistung liefert ein Snapdragon 865 Prozessor mit acht bis zu 12GB Arbeitsspeicher. Doch die beste Hardware bringt kaum etwas, wenn die Software schrott ist. Das System läuft unter Android 10 mit minimalen Anpassungen. Zur Abwechslung wirkten sich die Veränderungen positiv auf die Gesamtperformance aus, wie der Technik-YouTuber Kilian alias iKnowReview in einem seiner Videos berichtet.

Erstmals Wireless-Charging & Wasserschutz-Zertifizierung

Die interessant werdenden Unterschiede zwischen dem OnePlus 8 verglichen mit dem Pro-Smartphone liegen im Detail. Erstmals wird Wireless Charging, als auch Reverse Wireless Charging unterstützt. Mit der separat erhältlichen Lade-Basis, die sogar eine Kühlung verbaut hat, soll der Akku innerhalb von 30 Minuten auf bis zu 50% kommen. Das wäre kaum langsamer als das Aufladen mit dem kabelgebundenen Warp-Charge-Netzteil, das auch mit dem Einsteiger- Gerät funktioniert. Eine weitere Premiere feiert man mit der IP 68-Zertifizierung, wodurch bestätigt wird, dass die Geräte einerseits staubdicht und gegen dauerndes Untertauchen geschützt sind. Bisher mied das Unternehmen solch offizielle Auszeichnungen, um laut eigenen Angaben den Verkaufspreis niedrig halten zu können.

OnePlus' Trumpf: QuadHD+ mit 120Hz

Obwohl eine Auflösung von QuadHD+ und eine Bildwiederholrate von 120Hz, das heißt, dass sich der Bildschirminhalt 120 Mal/ Sekunde aktualisiert, an und für sich nichts neues sind, ist es trotzdem eine Erwähnung wert. Bisher musste sich der Anwender zwischen einer höheren Auflösung oder flüssigerer scheinenden Benutzung entscheiden. Mit dem OnePlus 8 Pro ist beides zeitgleich möglich.

Fazit: Neuste Technik & Spielereien, aber nicht mehr günstig

Mit den neuen Smartphones wirft OnePlus alte Gewohnheiten über Bord und betritt neues Terrain. Die Hardware ist nicht mehr das Nötigste reduziert worden, um auf diesem Weg das Gerät preiswert zu halten. Ein Beispiel gefällig? -Die "Farbfilter"-Kamera, die für kaum einen Filter genutzt wird. Oder das 5G-Modul, das in beiden Varianten verbaut ist. Versteht es nicht falsch, aber in wie vielen Jahren wird das flächendeckend verfügbar sein? Hätte man all das berücksichtigt, wären die neue OnePlus-Generation nicht so teuer, wie nie zuvor, denn die Anschaffungskosten liegen bei 699€ bzw. 899€ für Geräte mit 128GB. Für einen gewissen Aufpreis lässt sich der Systemspeicher auf 256GB verdoppeln. Fotografie-Enthusiasten sollten sich schon zu Beginn über ihren Speicherbedarf im Klaren sein, denn einen Steckplatz für microSD-Karten gibt es nicht; dafür Dual-SIM.

Hinweis: Der Beitrag entstand im Rahmen der Sendung radio.exe bei Radio Darmstadt. Alle Inhalte - Podcast & Skripte - gibt es online bei radioexe.de. Schalte an jedem vierten Sonntag im Monat ab 17:00Uhr live zu via 103,4MHz, DAB+ (Juli-Dezember) oder im weltweiten Stream!

©2020 Hessentrend/ Leon Ebersmann